苹果被传出正在研发VR或AR头显已经有一段时间了,各种报道和专利申请都表明它可能会有很多研发方向。周二美国专利和商标局授予苹果的一对专利中,又透露了该系统的两种功能方式,即苹果的AR头显或未来的iPhone可以利用显示屏光线来追踪几乎任何表面的运动,而手指设备可能会向系统提供用户可能接触到的物体细节。

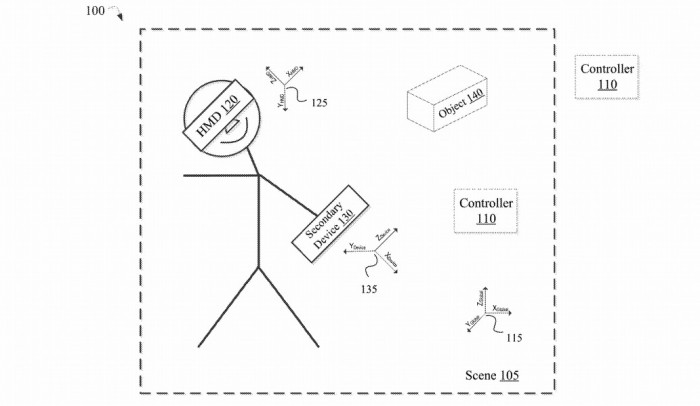

AR头显的优势之一是在设置中加入了摄像头。通常用于拍摄场景的图像和物体识别,同样的硬件可以用于执行物体跟踪,查看物品相对于头显位置的实时位置变化。然而,对象识别和对象跟踪所需的资源,完成确定方向,对系统来说是相当沉重的负担,因此苹果在这2项新专利当中可以解决此问题。

在名为 “带有事件摄像头的AV/VR控制器 “专利中,苹果提出了这样的想法:摄像头系统不一定需要时刻跟踪与被跟踪对象相关的所有像素,在只需要粗略检查的时候进行像素跟踪报,将跟踪数量减少到最低限度。苹果提出,系统会选择图像中与被追踪物体相关的特定像素,进而提供光照强度和其他属性的读数。在摄像头或物体移动或改变位置的情况下,这几个像素的光照强度变化会超过设定的限制,从而触发整个系统开始使用更多的资源搜索物体的变化情况。另外,系统可以不尝试检测物体,而是简单地搜索相同的光点。如果物体上有多个光点,而系统只跟踪这些光点,那么它可以使用很少的资源来确定位置和方向的变化。

虽然这些光点很容易是环境照明在物体外壳上的反射,但苹果似乎正在考虑可以使用其他物体产生的光源,比如LED指示灯或显示图案的显示屏。如果是后者,只要屏幕可见,就能为系统提供充足的定位和方向数据。这种基于光的参考点不一定是针对可见光,因为苹果建议照明模式可以包括非可见波长。这将提供一个不会被用户看到的隐藏系统,也有可能是一个可以隐形且使用不同光波长的系统,让系统可以与多个用户或物体一起工作。

第二项专利涉及数据收集,具体涵盖了系统如何获取用户触摸的信息。这样的系统需要知道如何重现用户触摸现实世界物品时可能感受到的感觉,让它能够用触觉反馈工具来模拟效果。在这项名为 “带有手指设备的计算机系统,用于采样对象属性 “的专利中,苹果提出了使用手指佩戴的设备,它能够检测用户可能接触到现实世界物体的特征。每一个手指设备内的传感器都能够读取用户所接触的现实世界物体表面的效果,例如表面轮廓、纹理、物体颜色和图案、声学属性以及重量。当与其他元素相结合时,例如头显上的摄像头,系统将能够收集到很多关于物体的数据,然后再提供给用户。

虽然戴在手指末端,但该专利表明用户仍能体验到触摸物体的感觉,因为指垫将保持畅通无阻。传感器可以通过接触延伸到指尖以外的突起物进行检测,或者通过检测用户手指触摸物体的方式变化进行检测。收集到的有关物体的数据可以被编译和归档,供系统以后使用,并可能作为数据库进行共享。然后,这些信息可以与触觉反馈元素一起使用,以模拟触摸用户或其他用户的对象。

苹果每周都会提交大量的专利申请,但虽然专利申请的存在表明了苹果研发工作感兴趣的领域,但并不能保证这些想法会出现在未来的产品或服务中。

转自 https://www.cnbeta.com/articles/tech/1057729.htm

Linuxeden开源社区

Linuxeden开源社区